요새 chatgpt, claude, gemini 와 같은 거대언어모델(LLM)은 단순한 기술을 넘어 일상과 업무 전반에 자리잡고 있다.

이 LLM은 무엇이고, 어떻게 문장을 생성하고, 질문에 답하고, 추론까지 가능한걸까??

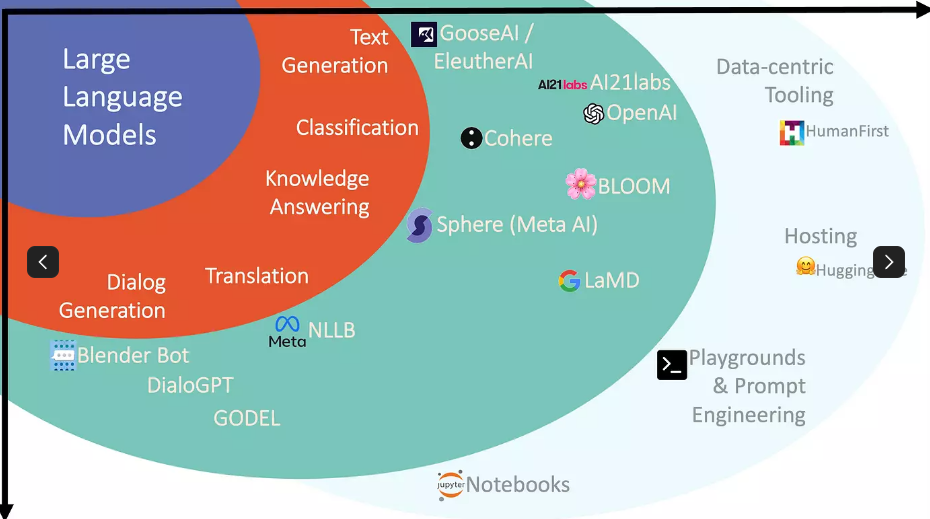

LLM

`Large Language Model`의 약자로 대형 언어 모델을 말한다.

그럼 LM(언어모델)은 무엇일까?

언어 모델은 언어라는 현상을 모델링 하고자 단어 시퀀스(=문장) 에 확률을 할당(assign) 하는 모델이다.

언어 모델은 크게 아래의 방법으로 만들어질 수 있다.

- 통계를 이용한 방법

- 인공 신경망을 이용한 방법

확률에 할당한다는게 이해가 잘 안됐는데 이런 느낌이라고 한다. (참고)

사람들이 I love you는 잘 말해도 I love me 는 잘 말하지 않는다.

모델이 이 패턴을 학습하면 I love 라는 말까지 나왔을 때 기계 입장에서는 i love you를 i love me보다 더 많이 학습했고, 가중치(weight)가 더 높음을 알 수 있다. 즉, 다음에 나올 말이 you 일 확률이 높다는 것을 알 수 있다.

하지만 이러한 방식으로 언어를 이해하려면 엄청나게 많은 양의 데이터를 학습해야 할텐데 옛날에는 하드웨어가 부족해서 데이터를 학습하지 못했다.

그런데 요새 하드웨어가 좋아지면서 많은 양을 학습할 수 있게 되었고, 그게 L(Large)LM이다.

LLM은 딥러닝의 방식으로 방대한 양을 사전 학습(pre-trained)한 전이(transformer) 학습 모델이라고 할 수 있다.

언어를 언어로 학습하려면 얼마나 많은 글을 학습했을지 감도 안온다... openai에서는 chatgpt 초기 모델 만드는데 460만달러가 들었다고 한다

Transformer

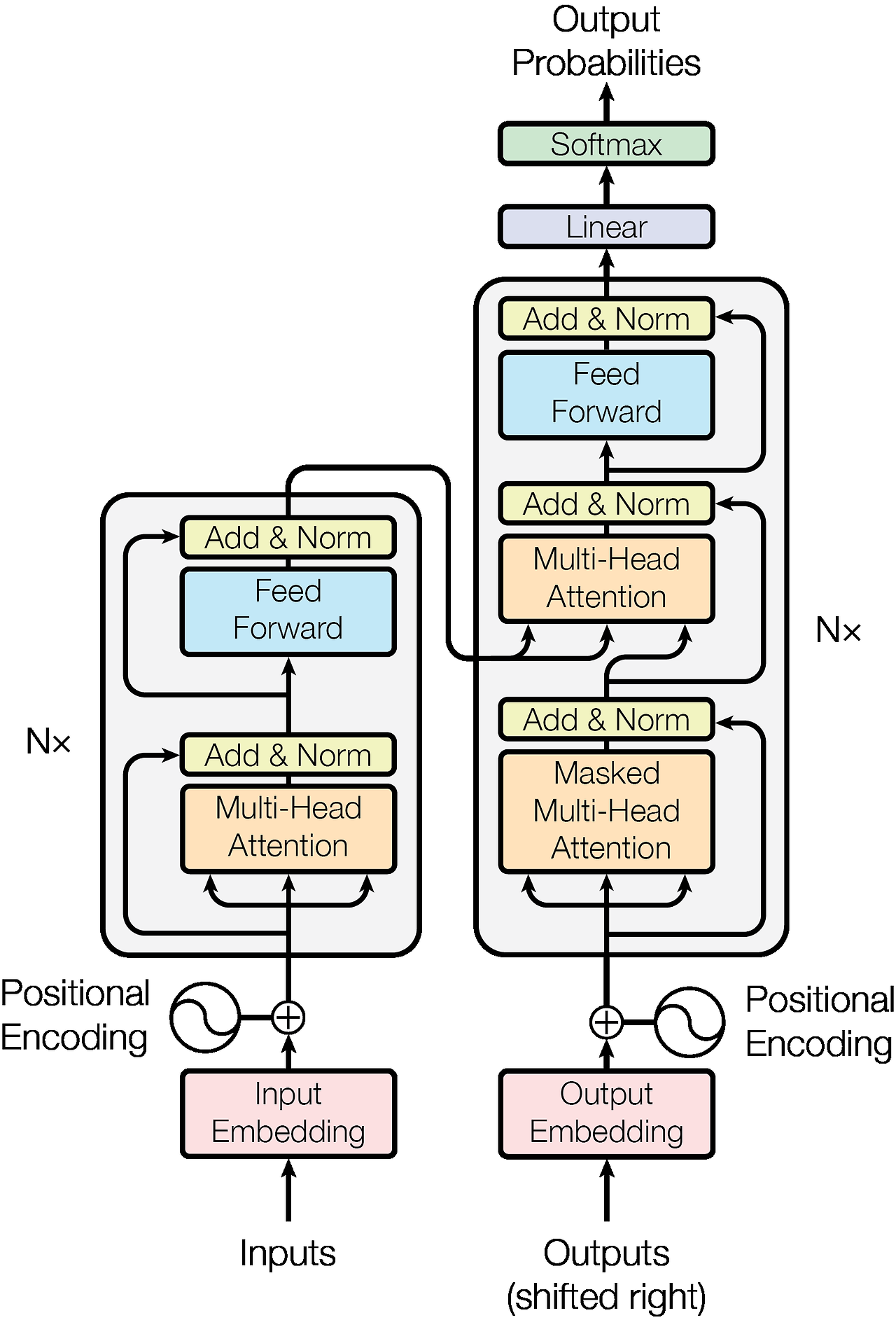

Transformer는 2017년 구글이 발표한 논문인 "Attention is all you need"에서 나온 모델이다.

기존의 encoder-decoder(seq2seq) 구조를 따르면서 Attention 만으로 구현한 모델이다.

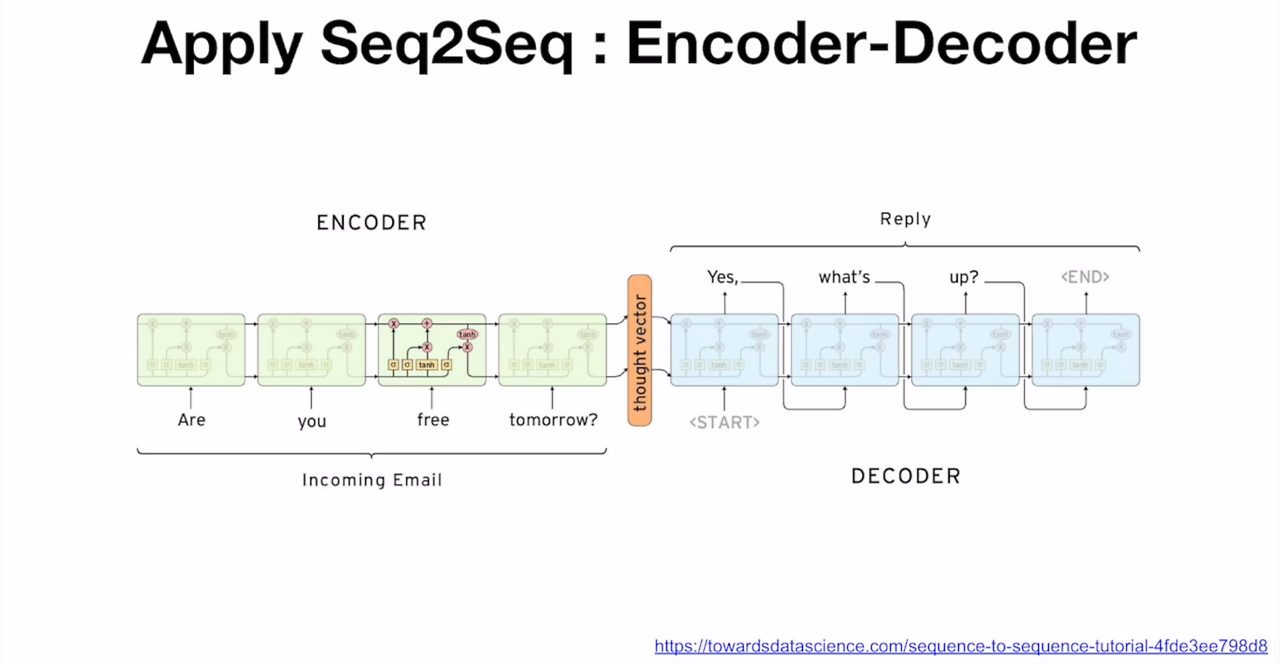

Sequence-to-Sequence (seq2seq)

시퀀스-투-시퀀스는 입력된 시퀀스로부터 다른 도메인의 시퀀스를 출력하는데에 사용된다.

* 참고: RNN과 seq2seq 차이

- RNN: 문장을 구성하는 단어가 입력되면 그떄마다 output을 만듦

- seq2seq: 모든 문장을 끝까지 들은 후 하나의 완전한 문장 생성

내부를 보면 Encoder와 Decoder라는 모듈로 구성된다.

- Encoder: 입력된 sequence를 벡터의 형태로 압축하여 decoder 전달 (=context vector)

- Decoder: 전달받은 벡터를 첫 셀의 hidden state로 넣어주고, start flag(문장의 시작임을 알림, sos)와 함께 모델 시작 셀에서 나온 output을 문장의 첫 단어로 두고 이것이 다시 두번째 cell의 input과 함께 들어가는 과정 반복

* hidden state: 모델이 입력 시퀀스를 처리하면서 현재까지의 정보를 압축한 요약 벡터 (현재 입력+과거기억)

하지만 여기에는 명확한 한계가 존재한다.

또 RNN의 고질적인 문제인 vanishing gradient 문제가 있고,

context vector가 압축을 고정된 길이로 하기 때문에 손실이 발생할 수밖에 없다.

encoder의 마지막 hidden state에 input 문장에 대한 모든 정보를 담아야 하고, hidden state에만 정보 전달을 의존하게되므로 앞쪽 정보를 거의 저장하지 못하는 문제가 발생할 수 있다. (=bottleneck problem)

따라서 문장이 길어질수록 성능은 저하된다.

그래서 Attention 메커니즘이 고안되었는데 Encoder의 최종에 hidden state만 사용하는게 아니라 모든 time step에 hidden state를 활용해 context vector를 구축하여 seq2seq 한계를 극복할 수 있다.

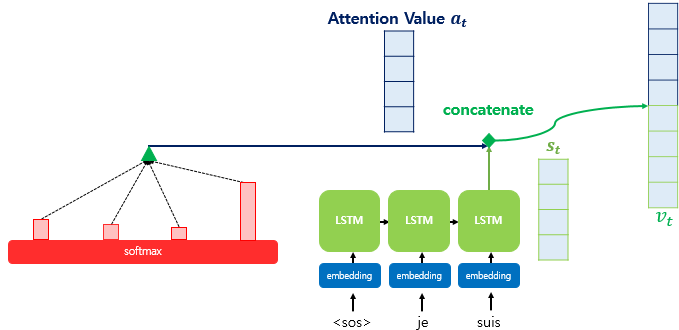

Attention

Attention은 기존의 고정길이 context vector로 인한 문제를 해결하기 위해 생겼다.

디코더에서 출력 단어를 예측하는 매 시점(time step) 마다 인코더에서의 전체 입력 문장을 다시 한 번 참고한다는 아이디어에서 출발한다.

다만, 문장을 전부 동일한 비율로 참고하는 것이 아니라 해당 시점에서 예측해야 할 단어와 연관이 있는 단어 부분을 집중(attention)해서 본다.

동작 방식은 여기에 순서대로 잘 설명되어 있다.

간단히 말하면

Encoder에 I am a student를 입력하고 Decoder의 3번쩨 LSTM cell (초록색)에서 출력 단어를 예측하는 상황이다.

Encoder에서는 단어를 하나씩 LSTM에 넣어서 은닉벡터를 구성한다. (=각 LSTM에서는 그 time step의 은닉 벡터를 가지고 있음)

Decoder에서는 현재 유추하려는 단어를 만들 때 가장 관련있는 Encoder의 단어가 무엇인지 찾으려고 할 것이다.

Decoder에서는 현재 상태의 은닉 상태를 가지고 encoder의 각 은닉상태와 내적하여 Attention Score (초록색 동그라미) 를 만든다. 이걸로 Attention Weight를 만들건데, 모두 양수이고 합이 1로 만들기 위해 softmax 과정을 거친다 (빨간색 세로로 긴 네모)

softmax까지 거치면 어떤 단어가 가장 연관성이 있는지 weight로 나타내기 위해 각 인코더의 은닉 상태와 attention weight를 곱하고 더해서(weighted sum) Attention value를 만든다. (초록색 세모)

즉 Attention Value는 encoder의 모든 은닉 상태 각각이 decoder의 현 시점의 은닉상태와 얼마나 유사한지 판단하는 값이다.

이렇게 구해진 Attention Value 와 St (디코더의 현 시점의 은닉상태)와 결합하여 하나의 벡터로 만든다 (Vt)

그리고 이 벡터를 예측 연산의 입력값으로 사용함으로써 더 잘 예측할 수 있도록 한다.

다만 attention value를 구하는 과정에서 내적을 할 때 순서 정보가 없다.

예를들어 (https://www.youtube.com/watch?v=6s69XY025MU)

"인도 음식점에 가던 중 주행 금지 표지판을 보았다" 라는 문장을 영어로 번역한다고 가정해보면

key를 아래와 같이 나눴을 때

- 인도

- 음식점에

- 가던 중

- 주행 금지

- 표지판을

- 보았다

"인도"라는 글자를 처음에 내적하든 나중에 내적하든 결과는 똑같다는 의미이다.

이 attention value값은 "인도 음식점에 가던 중 주행 금지 표지판을 보았다" 순서로 하는것과, "인도 주행 금지 표지판을 음식점에 가던 중 보았다" 순서로 하는거랑 동일하다.

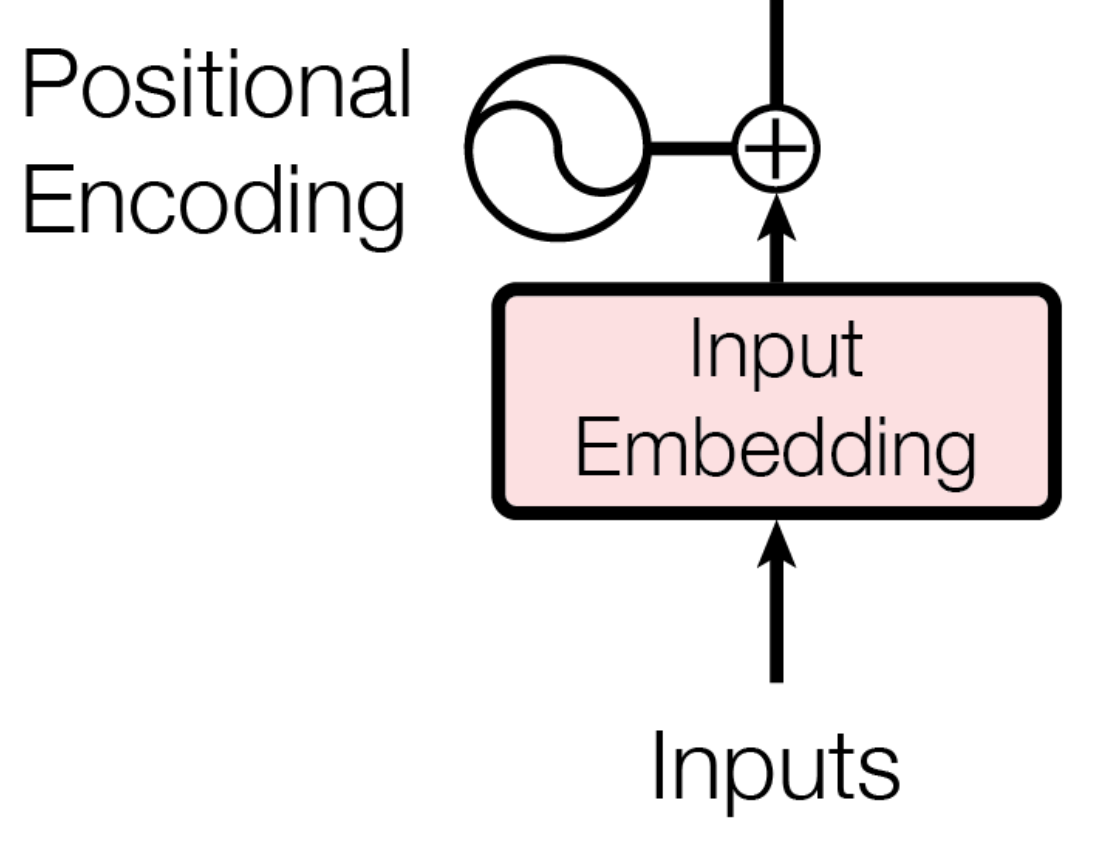

그러니까 잘 이해하고 번역하려면 단어 순서 정보를 넣어야 하는데 아래의 transformer에서 positional encoding 을 추가해 단어의 순서 정보를 추가한다.

추가로 RNN 계열은 네트워크를 계속 순환업데이트하는 구조다보니 연산 효율이 떨어진다.

Transformer에서는 RNN을 사용하지 않고 attention만을 이용해서 encoder-decoder 구조를 만들어서 연산 효율이 좋다고 한다.

Transformer

시간이 지나서 뭔가 많이 대체된 것 같은데 많은 분야에서 SOTA를 달성했다고 한다. (https://paperswithcode.com/sota)

transformer에서 인코더 입력 부분은 소스 시퀀스의 input embedding에 특정 위치마다 특정 벡터를 더하는 규칙을 둬서 positional encoding(위치정보)를 추가해서 만든다.

만약 "인도 음식점에 가던 중"을 "인도" "음식점에" "가던중"의 토큰 시퀀스로 나눴을 때 "인도" 에는 1번 flag 벡터, "음식점에"에는 2번 flag 벡터를 더하고, 각 단어의 벡터를 확인했을 때 몇 번째 단어인지를 알 수 있다.

하지만 positional encoding을 추가하는 것만으로는 아래 예시의 "인도"가 인도(India)인건지 인도(人道)인건지 알 수가 없다.

- 인도 음식점에 가던 중 주행 금지 표지판을 보았다.

- 인도 주행 금지 표지판을 음식점에 가던 중 보았다.

그러니까 인도 다음에 오는 글자를 참고 해야 인도 음식점인건지 인도 주행인건지를 맥락을 파악할 수 있다.

이는 Self-Attention이라는 메커니즘을 통해 맥락을 파악할 수 있다.

transformer에서 인코더와 디코더의 구조는 Self-Attention (노란색-주황색 네모)와 FFN(노란색-파란색 네모) 로 이루어져있다.

FFN은 그냥 linear layer라고 한다.

Attention에서 Key랑 Value값을 동일한 값을 쓸 때 Self Attention이라고 한다. 즉 자기 자신에게 attention을 하는 것이다.

Q="인도" 라고 하면 "인도~~보았다" 까지 내적한 key와 "인도~보았다"의 value를 계산해서 가중합을 만들고 이 결과를 다음 layer의 입력으로 들어가게 된다.

이 "인도"는 "인도~보았다" 각 단어의 관련정도가 반영된 하나의 가중치 합이므로

layer를 몇번 지나게 되면 그 뒤부터 "인도"는 그냥 인도가 아니라 "인도(그런데 뒤에 음식점이 붙은..)"이라는 의미를 내포하게 된다.

즉 맥락이 담긴 단어가 된다.

다른 과정은 seq2seq 이랑 비슷한 것 같다.

"나는 너를 사랑해"라는 문장을 영어로 번역하고, 세 번째 단어를 예측한다고 하면 encoder와 decoder에는 각각 아래의 input이 들어가게 된다.

- Encoder: 나는 너를 사랑해(위치정보 포함)

- Decoder: (sos) I Love (위치정보 포함, N-1번째까지의 output 결과)

GPT와 BERT

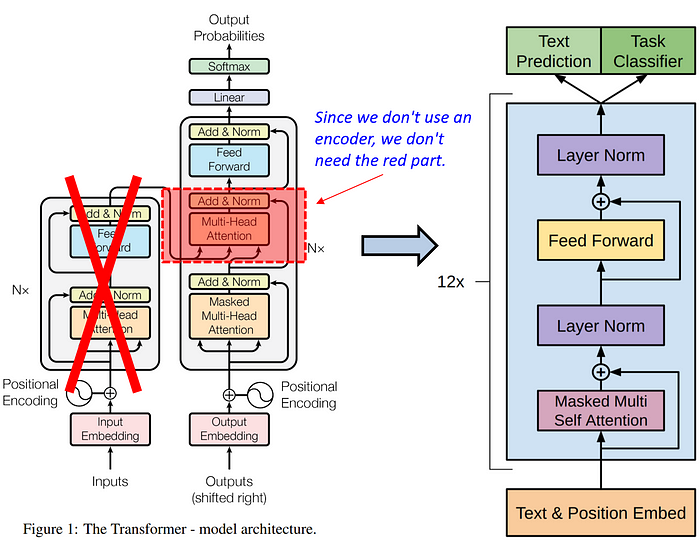

original transformer 의 구조는 입력 시퀀스를 이해하는 encoder와 출력 시퀀스를 생성하는 decoder로 나누어져 있다.

`input sequence`를 encoder를 통해 이해하고 `output sequence`를 decoder를 통해 생성한다.

하지만 굳이 인코더나 디코더가 필요하지 않을 수도 있다.

encoder를 뺀게 GPT(decoder only)고 decoder를 뺀 형태가 BERT(encoder only)로, 가장 성공적인 transformer의 변형이라고 한다.

두 모델의 공통점만 먼저 알아보자면 다음과 같다.

- Pretraining과 Fine-tuning: SSL(Self-Supervised Learning, unlabled data로 학습하는 기법)을 이용해 대규모의 데이터를 사전 학습

GPT

Generative Pre-trained Transformer

input sequence와 output sequence를 분리하지 않고 하나의 시퀀스의 형태로 간주하고 전체 시퀀스를 생성하도록 하는 모델링 방식이다.

기존에는 "나는 너를 사랑해"를 encoder가 처리하고, "I Love You" 를 decoder가 처리하는 방식인다.

하지만 하나의 시퀀스로 재구성하여

- "Translate Korean to English: 나는 너를 사랑해 => I love you"

라는 긴 문장으로 만들고 이 문장이 자연스럽게 생성되는 "I love you | Translate Korean to English: 나는 너를 사랑해" 를 모델링할 수 있다. 이러한 방식은 디코더가 주어진 입력 시퀀스의 문맥을 활용하여 출력을 직접 생성할 수 있기 때문에 디코더만을 이용해 구현할 수 있다.

OpenAI에서 개발한 GPT 모델은 이러한 방식을 채용하여 모든 텍스트 생성 작업을 디코더로 처리한다.

GPT의 구조는 입력을 받아 각 시점에서 모든 이전 output을 참고해 다음 outptu을 생성하는 방식으로 작동한다.

GPT는 언어를 학습시키는 데에 전통적인 언어 모델 방식을 채택했는데, 어떤 시퀀스가 주어졌을 때 다음 단어의 확률을 주어진 시퀀스를 이용하여 계산하는 방식이다. (Autoregressive Model)

"I Love"라는 시퀀스가 주어졌을 때 다음에 오는 단어를 예측할 때 GPT 모델은 "you"가 올 확률을 계산한다.

- P("you" | "I love")

이러한 방식으로 인터넷에 있는 방대한 양의 데이터를 이용해 문맥에 따라 다음 단어의 확률(=적합성)을 학습한다.

따라서 어떠한 단어가 주어졌을 때 정말 사람이 썼을 것 같은 문장을 생성해낼 수 있게 된다.

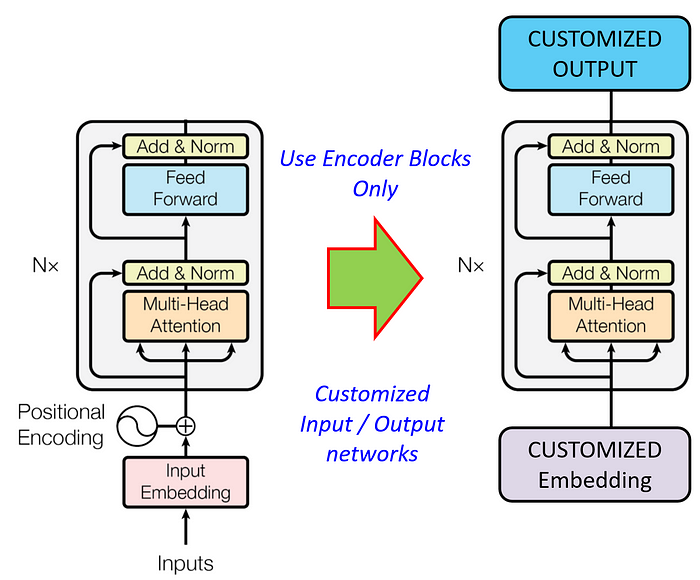

BERT

Bidirectional Encoder Representations from Transformers

분류나 회귀의 분야에서는 데이터를 숫자로 변환하는 것을 목표로 한다. (감정 분석, 주가 예측, 의료 진단 등)

이러한 작업은 출력을 생성하는 것이 아니라 숫자나 범위를 예측하는 것이기 때문에 디코더를 생략할 수 있다.

데이터를 숫자로 매핑하는 작업만 필요하기 때문에 인코더만 사용해도 되며, 대표적인 방식이 Google AI에서 개발한 BERT이다.

BERT에서는 언어를 학습할 때 MLM(Maksed Language Model) 방식을 채용했다.

MLM에서는 일부 단어가 Masked 처리가 되는데, 모델은 이 마스킹 된 단어를 예측해야 한다.

예를 들어 "Nice to meet you" 라는 문장에 "Nice to [masked] you" 이런 방식으로 마스킹을 할 수 있고 수많은 문제를 만들고 답을 만들어 배울 수 있다.

Nice to [masked] you 에서 [masked]를 예측할 때 앞에 있는 "Nice to"와 뒤에 있는 "you"를 모두 참고하기 때문에 Bi-directional 즉 양방향으로 문맥을 이해할 수 있다.

또 NSP(Next Sentence Prediction)를 이용해서도 모델링을 하는데,

- 나는 집에 들어갔다. 집에는 택배가 와 있었다.

는 이어질 수 있는 문장이지만

- 나는 집에 들어갔다. 바나나는 노란색이다.

는 이어질 수 없는 문장임을 이해하는 것이다.

GPT와 BERT의 차이를 요약하면 아래와 같다.

| GPT | BERT | |

| 모델 구조 | Transformer Decoder-only | Transformer Encoder-only |

| 입력 처리 | 왼쪽->오른쪽 순서대로 단방향 | 양방향(Bidirectional)으로 문맥 이해 |

| 학습 방식 | 다음 단어 예측 (Autoregressive) | 마스킹된 단어 복원 (Maked Language Modeling) |

| 사용 목적 | 텍스트 생성 | 텍스트 이해 |

| 활용 분야 | 챗봇, 문장 생성, 코드 생성 등 | 문장 분류, 질문 응답, 감정 분석 등 |

| 모델 예 | GPT-2, 3, 4 등 | BERT-base, BERT-large, RoBERTa |

참고

https://casa-de-feel.tistory.com/39

https://brunch.co.kr/@26dbf56c3e594db/110

https://kyull-it.tistory.com/212

https://velog.io/@sujeongim/NLPSeq2Seq-with-Attention

https://codingopera.tistory.com/41